文章来源:放心AI网发布时间:2025-04-29 13:39:27

Hugging Face 推出了一款令人瞩目的 AI 模型 ——SmolVLM。这款视觉语言模型的体积小到可以在手机等小型设备上运行,且性能超越了那些需要大型数据中心支持的前辈模型。

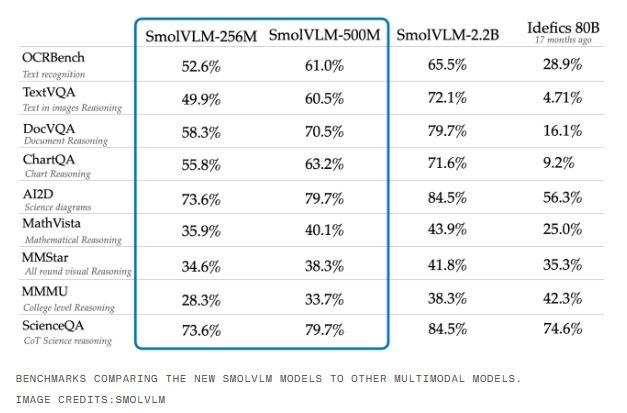

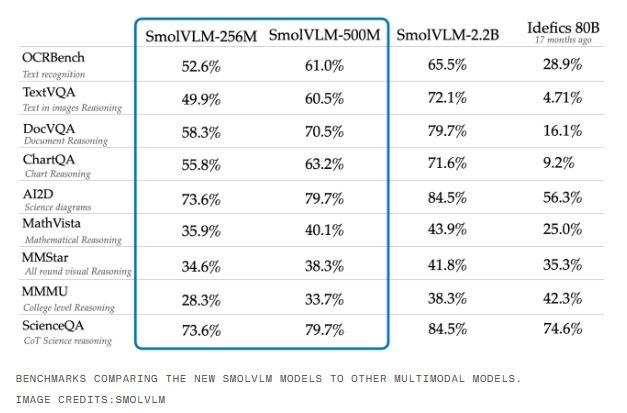

SmolVLM-256M 模型的 GPU 内存需求不足1GB,性能却超过了其前代 Idefics80B 模型,这一后者的规模是其300倍,标志着实用 AI 部署的一个重大进展。

根据 Hugging Face 机器学习研究工程师安德烈斯・马拉菲奥提的说法,SmolVLM 模型在推向市场的同时,也为企业带来了显著的计算成本降低。“我们之前发布的 Idefics80B 在2023年8月是首个开源的视频语言模型,而 SmolVLM 的推出则实现了300倍的体积缩减,同时性能提升。” 马拉菲奥提在接受《创业者日报》采访时表示。

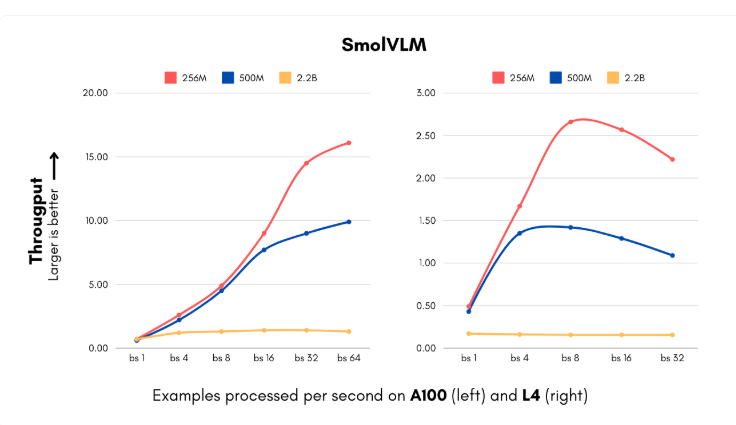

SmolVLM 模型的推出恰逢企业在人工智能系统实施方面面临高昂计算成本的关键时刻。新模型包括256M 和500M 两种参数规模,可以以以前无法想象的速度处理图像和理解视觉内容。最小版本的处理速度可达每秒16个实例,仅需15GB 的内存,特别适合那些需要处理大量视觉数据的企业。对于每月处理100万张图片的中型公司而言,这意味着可观的年度计算成本节省。

此外,IBM 也与 Hugging Face 达成了合作,将256M 模型集成到其文档处理软件 Docling 中。尽管 IBM 拥有丰富的计算资源,但使用更小的模型使得其以更低的成本高效处理数百万份文件。

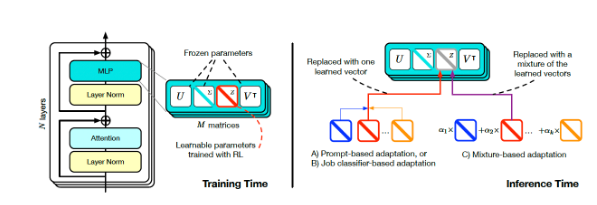

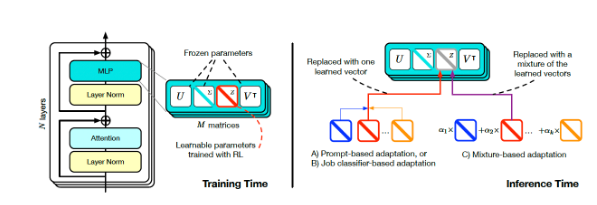

Hugging Face 团队通过对视觉处理和语言组件的技术创新,成功减少了模型规模而不损失性能。他们将原先的400M 参数视觉编码器更换为93M 参数版本,并实施了更激进的令牌压缩技术。这些创新使得小型企业和初创公司能够在短时间内推出复杂的计算机视觉产品,基础设施成本也大幅降低。

SmolVLM 的训练数据集包含了1.7亿个训练示例,其中近一半用于文档处理和图像标注。这些发展不仅降低了成本,还为企业带来了全新的应用可能性,使得企业在视觉搜索方面的能力提升至前所未有的水平。

Hugging Face 的这一进展挑战了传统对模型规模与能力之间关系的看法。SmolVLM 证明小型高效架构同样能够实现出色的表现,未来 AI 的发展或许将不再是追求更大的模型,而是追求更灵活高效的系统。

模型:https://huggingface.co/blog/smolervlm

相关攻略 更多

最新资讯 更多

300倍体积缩减!HuggingFace推SmolVLM模型:小巧智能,手机也能跑AI

更新时间:2025-04-29

琼海文远知行智能科技有限公司成立,专注人工智能软件开发

更新时间:2025-04-29

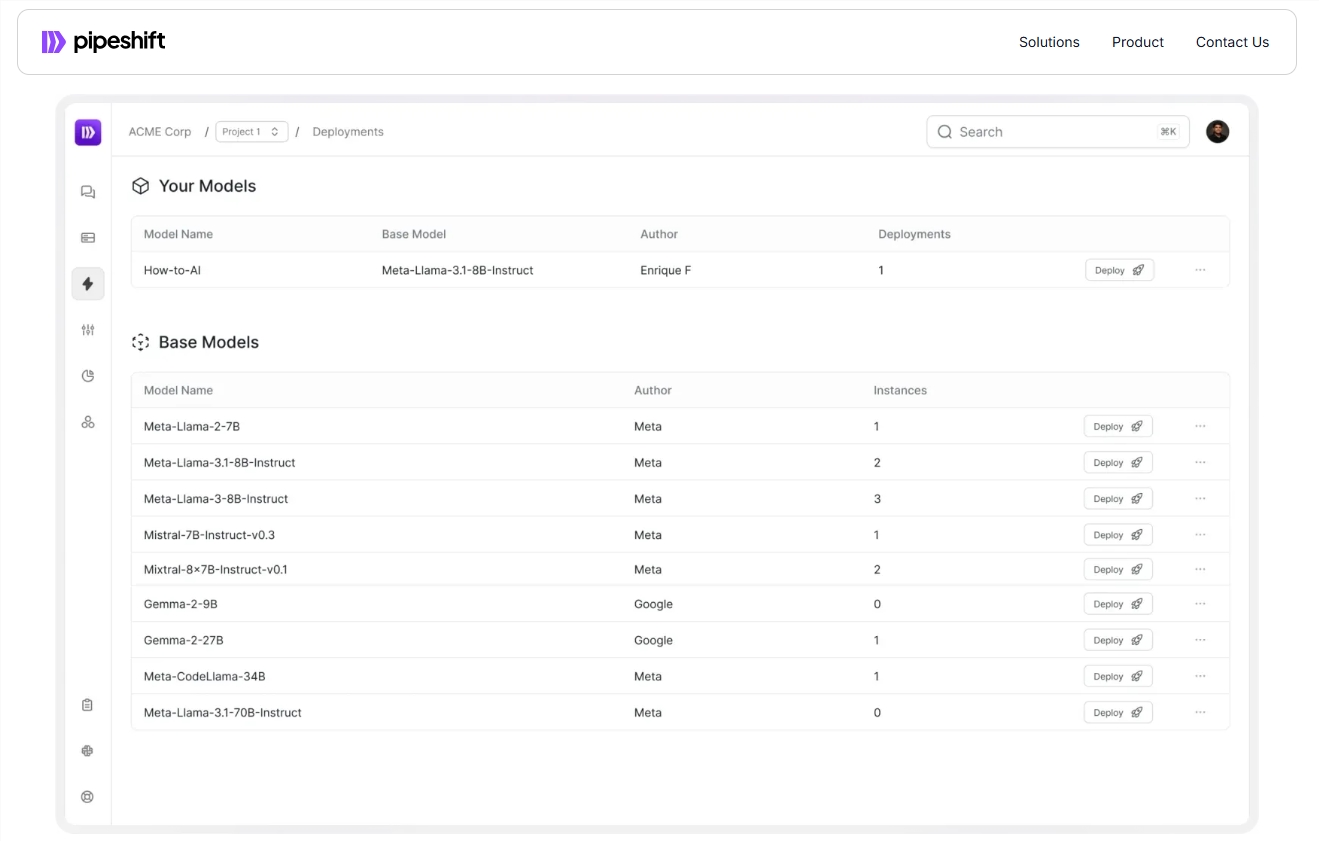

Pipeshift推出模块化推理引擎,实现AI推理GPU使用率降低75%

更新时间:2025-04-29

HuggingFace推出小巧AI模型,助力设备性能提升

更新时间:2025-04-29

发烧友!一国外软件工程师买下OGOpenAI.com域名并重定向至DeepSeek

更新时间:2025-04-29

元象推出智能数字人平台「元象日播」适配同音色多场景风格

更新时间:2025-04-29

SakanaAI的Transformer²模型突破LLM限制,实现动态推理

更新时间:2025-04-29

新型人工智能软件有望加速药物开发进程

更新时间:2025-04-29

IBM与欧莱雅联合开发AI模型打造智能化妆品

更新时间:2025-04-29

中国联通发布元景思维链大模型:性能超越GPT-4o比肩OpenAIo1

更新时间:2025-04-29