BLOOM,HuggingFace推出的大型语言模型(LLM)

放心AI网·扩展AI栏目来啦!小编带你挖掘那些小众但超好用的AI神器,错过就亏大啦~

BLOOM官网,HuggingFace推出的大型语言模型(LLM)

人人都能用的多语种大模型来了!支持59种语言,参数1760亿,1000名科学家联合发起!一直以来,很多大模型都由造它们出来的大型私营科技公司垄断着。比如GPT-3等,对于普通人来说,再香也只能眼巴巴看着。不过现在,为了给你解馋,由近1000名科学家联合发起的一个志愿项目,耗时一年多炼出了一个号称和GPT-3一样强大的语言模型。它的名字叫BLOOM,参数1760亿,不光支持英文或者中文,连西班牙语、法语等59种语言都支持,是目前最大的多语言开源语言模型。是的,从现在起,从代码到数据集,BLOOM全部对外开放,所有人都可使用。

BLOOM官网:https://huggingface.co/bigscience/bloom

BLOOM参考文档:

https://huggingface.co/docs/transformers/model_doc/bloom

BLOOM是一个BigScience项目,去年5月启动,由HuggingFace主导,收到了700万美元的公共捐款。共有来自全球60个国家、超过250个机构,以及超过1000名研究人员参与其中,其中包括以个人名义参加的Meta、谷歌等大厂员工。它的训练在法国超级计算机JeanZay上进行,共花费了384块A100GPU,其中每块有80GB内存,训练吞吐量约150TFLOP(该超算由低碳的核能提供动力,释放的热量还用来给学校供暖)。

然而,直到达到102%的时候,BLOOM才正式停止训练。在经过耗时117天的训练后,BLOOM在预定计划时间内顺利完成。

最终,BLOOM具备以下特点:

参数数量达到了1760亿,比GPT-3还多10亿。

模型包含70层,每层具有112个注意力头。

Token序列长度为2048。

采用了GeLU激活函数。

使用了总计3416亿条token(1.5TB文本数据)的数据集进行训练。

支持13种编程语言和46种自然语言。

值得一提的是,对于许多语言而言,如法语、西班牙语和阿拉伯语等,这是首次拥有自己的开源模型(尽管目前尚不支持日语,一些网友已经发现了这一点)。

此外,为了尽量减少生成结果中的偏见,参与项目的人员还经过了一轮人工过滤,对抓取到的数据进行了筛选。

目前,BLOOM的训练对硬件设备有一定要求:

为了保证最佳效果,最好配备8块80GB的A100显卡或16块40GB的A100显卡。

这意味着只有规模稍大的团队才能承担这样的训练需求。

当然,也可以选择在云平台上进行训练,每小时最高费用为40美元。

最后,BLOOM表示将降低使用门槛,并计划开发一个分布式系统,允许实验室之间共享模型。

BLOOM将成为一个不断发展的模型家族,而非一劳永逸的项目。

BLOOM模型已通过BigScienceWorkshop提出了各种版本。BigScience受到其他开放科学计划的启发,在这些计划中,研究人员汇集了他们的时间和资源,共同实现更高的影响。BLOOM的架构本质上类似于GPT3(用于下一个令牌预测的自回归模型),但已经在46种不同的语言和13种编程语言上进行了训练。模型的几个较小版本已在同一数据集上进行了训练。BLOOM有以下版本:

绽放-560m

绽放-1B1

布鲁姆-1B7

布鲁姆-3B

布鲁姆-7B1

绽放(176B参数)

官方拥抱面孔和社区(由表示)

需要网络免费

资讯AI更多

资讯AI 更多

西班牙拟立法打击AI生成的色情图像,保护未成年人隐私

更新时间:2025-03-26

吉卜力风格AI图刷屏,OpenAI测试GPT - 4o生图模型水印

更新时间:2025-04-08

快手发布财报:Allin视频大模型可灵AI商业化首战告捷

更新时间:2025-03-27

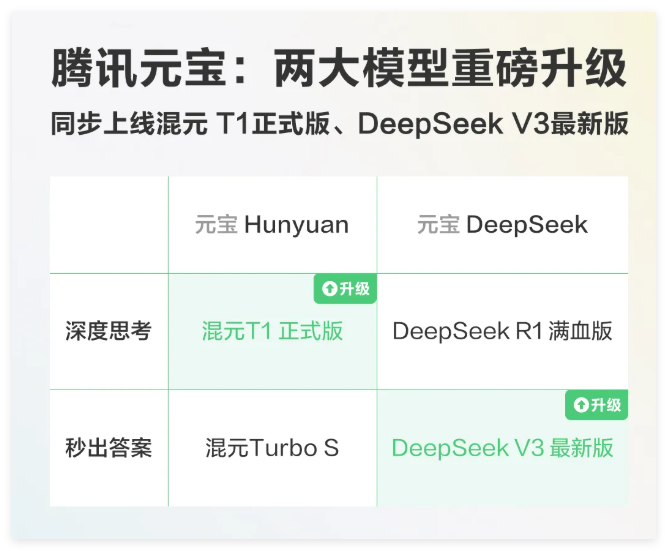

腾讯混元T1正式版和DeepSeekV3-0324上线元宝

更新时间:2025-03-29

互联网医疗AI布局提速,服务质量升级把握新契机

更新时间:2025-04-01

德克萨斯州Alpha学校应用AI辅导系统后,学生成绩提升至全美顶尖行列。

更新时间:2025-04-08

IDC发布报告:全球与中国AI市场投资规模将大幅增长

更新时间:2025-04-08

【重磅来袭】小米MIJIA智能音频眼镜2全新上市,轻薄设计实现录音控车功能,科技升级引领潮流!

更新时间:2025-04-08

全球首款智能体重管理助手“减单”诞生,开启健康新纪元。

更新时间:2025-04-09

Midjourney核心开发者theseriousadult离职,投身Cursor研发AI编程智能体

更新时间:2025-04-10